jeudi 1 novembre 2012

11:26

Alexandre Laumonier : « Après la crise de 2007, il fallait trouver une nouvelle vache à lait »

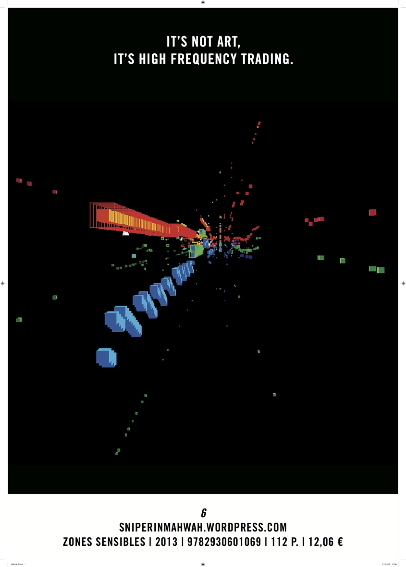

« La guerre animale est devenue algorithmique : froide, silencieuse et beaucoup plus rapide. » C’est en ces termes qu’Alexandre Laumonier évoque l’irruption du trading à haute-fréquence sur les marchés financiers. Une évolution qu’il a détaillé dans 6, portrait vivant et atterrant de la finance mondiale et de ses soubresauts mécanisés. Entretien.

Cet entretien a été publié dans le numéro 12 de la version papier d’Article11. Il porte sur un ouvrage intitulé « 6 », qu’Article11 a chroniqué ICI.

*

Alexandre Laumonier n’a pas franchement le profil type du spécialiste des marchés financiers. Ce n’est ni un trader repenti, ni un professeur d’économie reconverti, ni un technocrate pontifiant. Au départ, ce jeune éditeur belge était même plutôt spécialisé dans l’anthropologie. C’est sans doute pour cette raison que l’ouvrage qu’il a consacré à l’irruption des transactions à haute fréquence1 sur les marchés financiers n’a rien d’écrasant ou de soporifique. Le sujet a beau être d’une complexité effarante, lui est parvenu à le rendre aussi trépidant qu’un polar azimuté. 62 n’est pas seulement une enquête ultra-documentée, c’est le tableau vivant de la course en avant démentielle qui agite les hautes sphères de la finance, entre « soulèvement des machines », règne des algorithmes et dérèglements boursiers.

« Je ne voulais pas faire un livre politique à charge, mais exposer des faits et données parlant d’eux-mêmes. Le système est suffisamment monstrueux pour que sa folie saute aux yeux », confie Alexandre, alors que nous évoquons 6 dans un bar situé à deux pas de la (défunte) Bourse de Paris. Il explique s’être lancé dans ce projet en découvrant l’existence des data centers3 qui se sont substitués aux parquets des places boursières comme centres névralgiques de la finance. Quand il a compris que le sujet était largement méconnu, quasi terra incognita, il a décidé de persévérer, a dévidé le fil, patiemment. Il continue de le faire4.

*

Quelle est la part des transactions à haute fréquence dans les échanges financiers ?

Lorsque je terminais l’écriture de 6, en 2012, elles représentaient entre 60 et 70 % des échanges boursiers aux États-Unis. Ce pourcentage a depuis nettement chuté, mais il dépasse encore les 50 %. Et ce chiffre ne concerne que les transactions réelles réalisées par les algorithmes, et non les cotations (les discussions permettant d’atteindre un prix acceptable pour le vendeur et l’acheteur). Or, il y a des milliards et des milliards de cotations qui sont chaque jour le fait d’algorithmes ; seulement 5 % donnent lieu à des transactions.

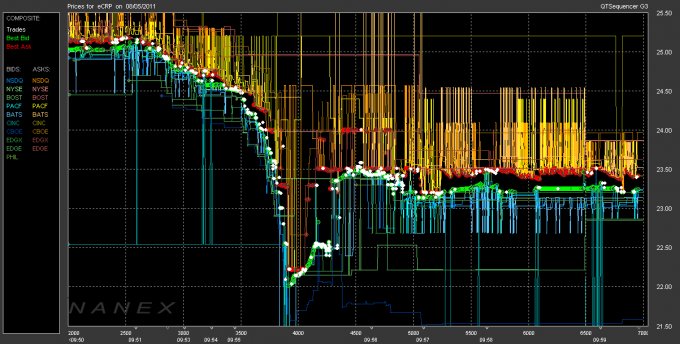

Cette inflation des cotations et la fragmentation du marché en des dizaines de plateformes électroniques débouchent sur une situation d’une complexité hallucinante, où les algorithmes gèrent un nombre incroyable d’informations. C’est un cercle vicieux : leur propre activité augmente le nombre d’informations, pour eux-mêmes et pour les autres. Sur la longueur, l’ensemble devient impossible à gérer : les algorithmes ne sont plus capables d’analyser toutes ces informations en quelques millisecondes. Pire, chaque nouvelle innovation suscite une surenchère. Certains en sont aujourd’hui à concevoir des algorithmes qui analysent Facebook et Twitter pour prendre des décisions. L’idée : sortir des seules données du marché pour démultiplier les possibilités d’anticipation. La chute vertigineuse des marchés américains le 23 avril dernier (136 milliards de dollars évaporés en trois minutes) en est une bonne illustration : elle faisait suite à un simple tweet d’Associated Press, dont le compte Twitter avait été piraté.

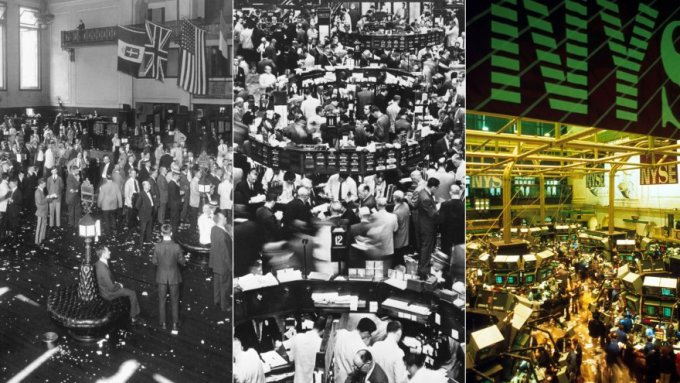

Le New York Stock Exchange en 1918, 1962 et 1987

Pour cet entretien, on est juste à côté de la dite « Bourse de Paris ». Mais c’est un bâtiment vide...

Parler de « Bourse de Paris » ne veut plus dire grand-chose – n’en déplaise à Jean-Pierre Gaillard. Elle a en effet fusionné avec Amsterdam, Lisbonne et Bruxelles en 2000, pour former Euronext. Puis Euronext s’est associé avec le New York Stock Exchange (NYSE) en 2007, ce qui a donné NYSE Euronext. Les plateformes informatiques qui gèrent ces marchés sont installées à Basildon, en banlieue de Londres.

Basildon est un gigantesque data center, un entrepôt sécurisé d’une surface équivalente à cinq stades de football, en grande partie vide. Il a été pensé pour résister à la chute d’un avion, avec des murs de quatre mètres d’épaisseur. Il héberge les plateformes correspondant à chaque marché, qui ont la taille d’une armoire et ressemblent à de gros frigos. Elles sont entourées des serveurs des opérateurs de marché (banques, courtiers), lesquels hébergent les algorithmes qui vont analyser les données contenues dans les plateformes puis prendre les décisions adéquates. Le tout dégage énormément de chaleur et doit sans cesse être refroidi, d’où la surface gigantesque de l’endroit. Un énorme stock de glace est par ailleurs stocké sur place, pour pallier une éventuelle défaillance du système de refroidissement.

L’humain a été totalement évacué du fonctionnement des marchés ?

Oui… et non. C’est toujours plus ambigu que ça. L’humain a été en bonne part évacué du processus de formation des prix, car les machines sont bien plus rapides – l’homme ne peut plus suivre en temps réel les activités des marchés. Les salles de marché aujourd’hui, ce sont des open space avec des gens devant des écrans ; ils choisissent quel algorithme utiliser, puis le regardent faire son office.

Mais si les algorithmes ont remplacé les humains en ce qui concerne les transactions réalisées, l’intelligence humaine n’a pas pour autant été mise au rencard. C’est elle qui conçoit les modèles mathématiques et les infrastructures techniques qui permettent ces transactions. En l’espèce, il s’agit souvent de gens issus des sciences cognitives, voire du nucléaire ; ils codent des algorithmes ou modélisent des programmes informatiques. Ce sont eux qui détiennent désormais le pouvoir sur les marchés.

Le grand essor des algorithmes date de 2007 et du déclenchement de la crise financière...

Les banques se sont ruées sur les algorithmes à partir de la crise (même si le soulèvement des machines algorithmiques débute en réalité une vingtaine d’années plus tôt). Certaines personnes travaillant dans de grandes écoles de finance m’ont ainsi confirmé avoir reçu en 2007 des coups de fil de banques pour les inciter à former des gens maîtrisant davantage les algorithmes. Les modèles mathématiques ayant failli, il fallait trouver une autre vache à lait.

En 2007 s’est en effet produit un effondrement de certains modèles mathématiques notamment liés aux CDO et CDS – ces sympathiques produits dérivés sur les crédits, responsables en partie de la crise mondiale. Les banques se sont alors retrouvées sur la sellette, unanimement critiquées. Or ces dernières sont là pour faire de l’argent, et à court terme. Dans un contexte de crise aiguë et d’absence de liquidité, elles se sont tournées vers les machines : il s’agissait de tenter de gagner quelques cents en quelques millisecondes plutôt que d’investir sur les produits dérivés, désormais très mal vus (ils sont toujours utilisés, mais plus discrètement).

Les racines de ce revirement sont en réalité plus profondes ; une conjonction d’élément y participe. Avec une première vague technologique et informatique, qui remonte aux années 1960. Puis une deuxième vague, qu’on pourrait qualifier « de consolidation » et qui structure le marché au début des années 2000 – citons le cas de Goldman Sachs ou de Crédit Suisse, qui rachètent alors des sociétés de technologies financières développant des algorithmes de transactions. Enfin, la dernière vague est liée à un événement précis, à savoir la crise économique. Voilà ce qui se joue en 2007 : une construction sur le long terme se confronte à une crise, avec en sus des dérégulations qui tombent au « bon moment ».

Cette année-là, une série de mesures de dérégulations libéralise en effet totalement les marchés. C’est la fin du capitalisme à l’ancienne. Pendant deux siècles, les marchés avaient été neutres, mutualisés ; mais d’un seul coup, les régulateurs les autorisent à se coter eux-mêmes en Bourse, comme n’importe quelle autre firme. Qui a alors racheté les marchés ? Les banques, et quelques gros opérateurs type Knight Capital ou Citadel – le plus gros hedge fund américain. Le moment est essentiel : c’est seulement une fois le système libéralisé et les marchés fragmentés que les machines ont commencé à réellement monter en puissance.

Le tableau d’ensemble est d’une complexité effarante... Il y a des gens qui y comprennent quelque chose ?

Pas grand monde. Un trader du nom de Bruno Iksil, surnommé « la baleine de Londres », a récemment fait perdre six milliards d’euros à JP Morgan, la plus grosse banque américaine. Il se trouve que les traders qui manipulent des algorithmes ou des modèles mathématiques utilisent entre eux un langage particulier, une sorte de slang, d’argot. Et la directrice du management du risque de JP Morgan, celle qui était justement censée surveiller le travail de Bruno Iksil, a fini par avouer devant le Sénat américain qu’elle ne comprenait pas les mails qu’il lui envoyait. Le trader a lui aussi témoigné devant le Sénat, et il s’est passé la même chose : personne n’a compris ce dont il parlait.

Cette complexité résulte d’un véritable emballement technologique et intellectuel. Il y a trente ans, il était encore possible d’avoir un point de vue détaillé de l’ensemble ; aujourd’hui, plus personne n’en est capable. Aussi doué et compétent soit-il, un observateur ne peut que se perdre entre les modèles mathématiques, les modèles des algorithmes, les plateformes, les routages des ordres...

Cette obscurité n’est pas seulement celle des marchés, elle règne sur le monde de la finance en général. Ceux qui en tirent profit ont tout intérêt à ne pas rendre publiques leurs activités. Mais eux-mêmes se trouvent en réalité désemparés par cette complexité. J’ai récemment discuté avec deux journalistes suisses, qui viennent de publier Krach Machine5 ; ils m’ont expliqué qu’au siège de certaines banques à Genève, les spécialistes financiers ne sont absolument pas au courant de ce qui se passe du côté des modèles mathématiques et des algorithmes.

En regard de cette complexité, le traitement médiatique se révèle particulièrement indigent...

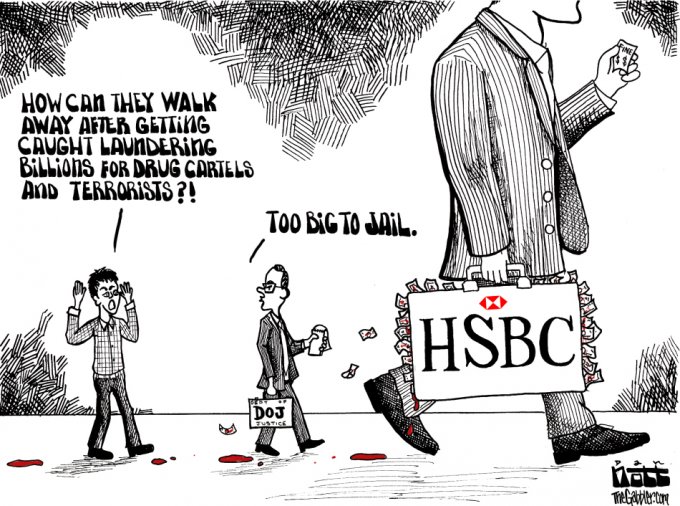

C’est effarant, particulièrement en France. J’ai été très choqué, par exemple, de voir que personne ne parlait de la récente audition devant le Sénat américain du procureur général le plus haut placé dans le système judiciaire des États-Unis, Eric Holder, un ancien conseiller d’Obama. Au cours de cette audition, un sénateur a abordé le cas de la banque anglaise HSBC. Celle-ci a visiblement blanchi, via sa filiale au Mexique, des centaines de millions de dollars générés par le trafic de cocaïne, et vient d’accepter de payer deux milliards de dollars pour échapper à des poursuites judiciaires. Le sénateur s’étonnait donc que les poursuites aient été abandonnées : si HSBC a accepté de payer une telle somme, c’est bien que la douloureuse aurait été encore plus salée si un procès s’était tenu. Pourquoi transiger, alors ? Le procureur général, censément garant du droit, lui a répondu que les banques sont devenues tellement puissantes que les poursuivre risquerait de déstabiliser l’économie américaine, voire mondiale. Soit « too big to jail » : trop grosses pour être punies.

Cela n’a pas fait de bruit, sinon sur quelques sites américains spécialisés. Le New York Times a un peu évoqué l’audition, deux ou trois autres journaux américains en font de même, sans s’attarder. Mais à ma connaissance, aucun journal français n’en a parlé. Il s’agit pourtant d’un témoignage fondamental. Non pas parce qu’il montre que le fric des trafiquants de cocaïne mexicain est blanchi par l’une des plus grosses banques du monde – rien de neuf –, mais parce que le grand patron du système judiciaire américain reconnaît officiellement que le droit a capitulé face à la finance.

On peut comprendre que les financiers maintiennent une certaine discrétion sur leurs activités. Mais que les médias fassent de même est vraiment choquant. Il n’y a personne chez les journalistes pour aller au cœur des sujets. Ni même pour expliquer des choses simples aux lecteurs. Par exemple : quand on vous parle de la Bourse de Paris, ça renvoie à quelque chose qui n’existe plus en tant que tel. Ou encore : les images de types s’agitant devant des écrans à Wall Street ne correspondent plus à rien, puisque la plupart des échanges se déroulent dans un entrepôt du New Jersey, à Mahwah.

Déni, gestion prétendument calculée des risques : le modèle actuel de la finance semble proche de celui de l’industrie nucléaire…

Il y a beaucoup de points communs. Avec le nucléaire comme avec le trading à haute fréquence, on se trouve face à quelque chose qui dépasse l’homme. Et des avertissements plus ou moins graves et occultés le rappellent régulièrement. Selon Nanex6, il se produirait dix mille mini-krachs par an, qui se jouent à la milliseconde. Avec parfois de plus grandes alertes, comme le « flash crash » du 6 mai 20107.

Dans le nucléaire et le trading à haute fréquence, on parle d’ailleurs de « management du risque ». Parce qu’il y a des choses qu’on ne maîtrise tout simplement pas. C’est ce qu’expliquait un ancien ponte des marchés dans un récent entretien à Trader Magazine : cette histoire de millisecondes a débouché sur une situation complètement ingérable.

Autre passerelle entre ces deux mondes : quelques-uns des ingénieurs ayant participé au programme atomique américain pendant la Seconde Guerre mondiale ont ensuite créé des algorithmes appliqués aux jeux d’argent, avant de se reconvertir dans la haute finance. Depuis Santa Fe, une ville en plein milieu du désert d’Arizona, ils ont par exemple conçu des systèmes informatiques pour anticiper la case où la bille de la roulette s’arrêtera. Puis ils les ont adaptés aux marchés financiers, avant de vendre l’ensemble à UBS, une grosse banque suisse.

Que ces gens soient issus du nucléaire n’est pas anodin – les problématiques sont proches, notamment en terme de temps. À Los Alamos, où a été mise au point la première bombe A, l’un des soucis des scientifiques tenait à la rapidité de déclenchement du champignon : plus il était rapide, plus était efficace l’explosion. Ils arrivaient à 16 millisecondes.

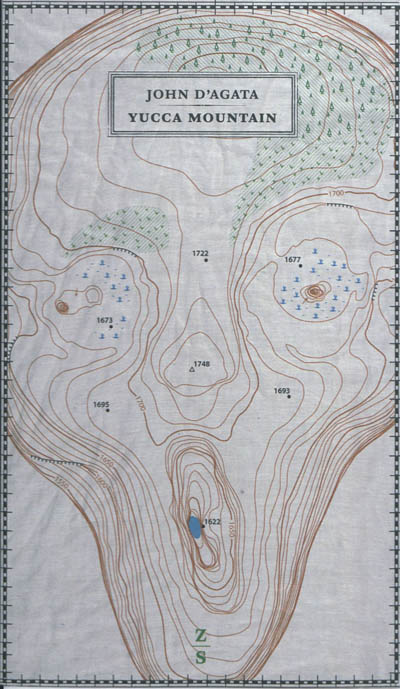

J’ai échangé quelques mails avec John d’Agata, l’auteur de Yucca Mountain8. Et nous nous sommes aperçus que nous étions confrontés à des problématiques similaires, moi traitant du trading à haute fréquence et lui des stocks de déchets nucléaires. Il est certes question de quelques millisecondes dans un cas et de centaines de milliers d’années dans l’autre, mais il s’agit à chaque fois d’une temporalité qui ne se maîtrise plus.

Tu t’es lancé dans cette enquête alors que tu menais des études d’anthropologie. Que t’as apporté cette approche ?

En ce moment, je travaille sur l’histoire du marché des matières premières de Chicago. Avant l’arrivée de l’informatique, le parquet du Merc (le Chicago Mercantile Exchange) était le plus gros au monde. Et les traders y travaillaient dans une atmosphère très animale. Ils étaient pressés les uns contre les autres, criaient, utilisaient des dizaines de signes de la main, se démenaient pour passer des ordres. Il fallait se battre, tout le monde était en sueur. Un homme petit et fin n’avait aucune chance de devenir trader sur le parquet – dans la cohue, il n’aurait pas été assez grand pour bien voir les autres, donc pour communiquer. Certains ont alors commencé à porter des talons de plus en plus hauts pour mieux interagir avec leurs interlocuteurs et prendre leurs décisions plus rapidement ; le Merc a dû en limiter la hauteur.

Dans l’ensemble, c’était très corporel. Par exemple, si tel type avait une goutte de sueur sur le front, les autres savaient qu’il se passait un truc. L’intonation d’une voix pouvait permettre de saisir un non-dit. Et c’est souvent à partir d’éléments physiques que les traders prenaient leurs décisions. Aujourd’hui, le physique a disparu, mais l’agressivité est restée. La guerre animale est devenue algorithmique : froide, silencieuse et beaucoup plus rapide.

Pour moi qui viens de l’anthropologie, ces évolutions sont fascinantes. La disparition de la goutte de sueur, voilà ce qui m’intéresse. C’est la différence entre l’humain et le non-humain. Le premier interprétait comme une information la sueur, une paire de lunettes de travers ou une cravate mal mise ; le deuxième en est incapable. Si les algorithmes s’observent les uns les autres, c’est une observation purement mathématique, bêtement rationnelle.

1 Selon Tata Wikipédia, « Les transactions à haute fréquence, ou trading haute fréquence, sont l’exécution à grande vitesse de transactions financières faites par des algorithmes informatiques. Ces opérateurs de marché virtuels peuvent ainsi exécuter des opérations sur les bourses en un temps calculé en microsecondes. »

2 L’ouvrage a été publié fin 2012 aux belges éditions Zones Sensibles, Alexandre Laumonier le signant du pseudonyme Sniper.

3 Centres de traitements des données – en l’occurrence, de gigantesques entrepôts bourrés de serveurs informatiques.

4 Une suite, 5, est en préparation.

5 Calmann-Lévy, 2013.

6 Société privée qui a développé un logiciel de surveillance des activités de marchés.

7 Ce jour-là, l’indice Dow-Jones a perdu plus de 9 % de sa valeur en moins de dix minutes.

8 Également publiée par Zones Sensibles (en 2012), cette (magistrale) enquête porte sur un gigantesque projet de stockage des déchets nucléaires dans le désert du Nevada.

Collé à partir de <http://www.article11.info/?Alexandre-Laumonier-Apres-la-crise>