Yoshua Bengio, chercheur : « Aujourd’hui, l’intelligence artificielle, c’est le Far West ! Nous devons ralentir et réguler »

Le chercheur canadien, précurseur des réseaux de neurones artificiels, a signé l’appel à un moratoire sur le développement des applications d’intelligence artificielle comme ChatGPT. Il en explique les raisons dans un entretien au « Monde ».

Propos recueillis par Claire Legros

28 avril 2023

Il n’a jamais voulu céder aux sirènes du privé, malgré les sollicitations. Pionnier de l’intelligence artificielle (IA) et prix Turing 2018 − considéré comme le Nobel d’informatique, qu’il a reçu aux côtés du Canadien Geoffrey Hinton et du Français Yann Le Cun −, Yoshua Bengio est un défenseur opiniâtre de la recherche publique. Le chercheur canadien enseigne à l’université de Montréal, où il a fondé MILA, l’institut québécois d’intelligence artificielle. Il s’est aussi engagé, en 2018, en faveur d’un développement responsable de l’IA, en participant à la rédaction de la Déclaration de Montréal.

Depuis que l’agent conversationnel ChatGPT a créé la surprise en répondant de façon impressionnante – mais pas toujours fiable – à toutes sortes de questions, le Québécois réclame une pause dans le déploiement de ces systèmes qui passent « haut la main le test de Turing », affirme-t-il. Il a signé la lettre de l’Institut Future of Life appelant à un moratoire de six mois, tout en précisant qu’il ne partage pas la vision « long-termiste » de ceux qui l’ont rédigée (le long-termisme est un courant de pensée qui donne la priorité à l’amélioration de l’avenir à long terme de l’humanité, au détriment du présent).

Yoshua Bengio et Yann Le Cun, amis de longue date depuis leur toute première collaboration à la fin des années 1980, portent des regards très différents sur les enjeux éthiques de ces nouveaux outils. Quand le premier s’inquiète et veut « ralentir », le second s’enthousiasme et affirme, au contraire, qu’« il faut accélérer ». Parce que leur débat met en lumière, à la croisée de l’éthique des sciences, de l’économie et du politique, les enjeux cruciaux de gouvernance de l’IA, nous les avons interrogés tous les deux et publions, de façon concomitante, leurs entretiens.

Pourquoi avez-vous signé la lettre réclamant une pause dans le développement des applications d’intelligence artificielle telles que ChatGPT ?

J’ai signé cette lettre dans le but d’alerter la société sur la nécessité de ralentir le développement de systèmes d’intelligence artificielle, qui s’est accéléré au détriment du principe de précaution et de l’éthique. La diffusion rapide de la nouvelle version de ChatGPT, beaucoup plus compétente que la précédente, m’a décidé. Ce système de langage à très grande échelle passe haut la main le test de Turing, c’est-à-dire qu’on ne peut pas facilement savoir, lorsqu’on converse avec lui, s’il s’agit d’une machine ou d’un humain. Cette nouvelle étape est passionnante, mais elle pourrait aussi entraîner des catastrophes.

Quels risques vous semblent les plus importants ?

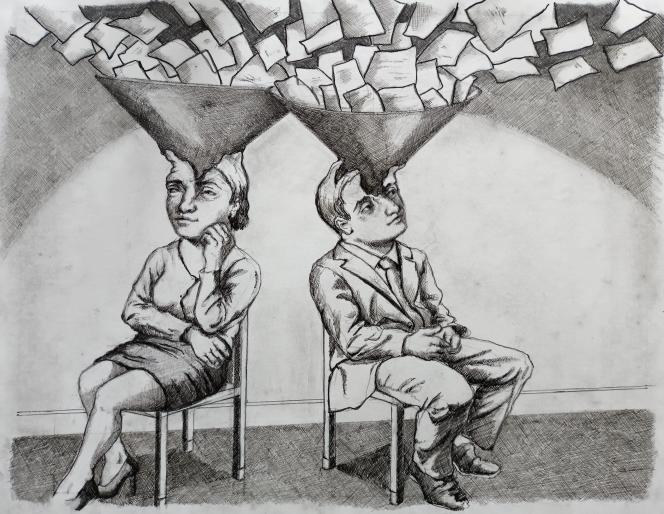

Le risque de désinformation arrive au premier rang. Entre la polarisation politique et les manipulations sur les réseaux sociaux, le débat public est mal en point. Ces systèmes peuvent amplifier le phénomène en produisant massivement des textes ou des images personnalisés, fabriqués dans le seul but d’orienter vers des idées fausses, et qui bénéficient à quelques-uns. Je crains que leur déploiement n’ébranle un peu plus nos démocraties.

Je suis inquiet aussi des risques dans le domaine militaire, où ces outils peuvent être redoutables en cas d’interception des communications. Les conséquences sur l’emploi, notamment dans les métiers qui utilisent le langage, me préoccupent également. Même si ces risques ne sont pas immédiats, il faut repenser dès maintenant le filet social et la formation des populations concernées.

En quoi ces systèmes s’apparentent-ils aux « boîtes noires imprévisibles » que décrit l’appel au moratoire ?

Si nous parlons de « boîtes noires », c’est parce que ces outils n’ont pas été explicitement programmés comme des logiciels classiques auxquels on commande d’effectuer une tâche. Les réseaux de neurones qui font appel à l’apprentissage profond sont capables d’apprendre à partir des données qu’on leur a fournies, et sont entraînés à imiter la façon dont les humains conversent entre eux.

Les résultats restent imprévisibles, et nous ne comprenons pas parfaitement le fonctionnement de ce processus très complexe. Cela pose des questions de sécurité, de transparence, de fiabilité. On s’aperçoit très vite que ces systèmes inventent parfois des réponses, qu’ils peuvent aller dans une direction que n’ont pas choisie les programmeurs. La seule façon de les réorienter, c’est de les récompenser lorsque la réponse est pertinente. Depuis des mois, les concepteurs de ChatGPT travaillent à parer les coups, mais ce n’est pas suffisant.

Pensez-vous que des machines puissent, un jour, égaler ou dépasser l’intelligence humaine ?

Nous en sommes encore loin. Les systèmes que nous arrivons à fabriquer pensent un peu de la même façon que lorsque nous parlons, parfois, sans réfléchir. Leurs capacités s’apparentent à notre intelligence intuitive. Ils sont entraînés comme des sportifs de haut niveau, excellents dans leur domaine, qui ont énormément pratiqué leur discipline et ne savent plus très bien pourquoi ils agissent d’une façon ou d’une autre. Mais, à la différence des sportifs, qui peuvent modifier eux-mêmes leur pratique en s’entraînant, ces systèmes n’ont pas la capacité de réfléchir sur leur fonctionnement.

Il existe des recherches en IA pour développer des systèmes qui imitent la façon dont nous pensons et dont nous sommes capables de justifier une décision. Il y a quelques années, je ne croyais pas que de tels travaux pourraient aboutir. Aujourd’hui, je suis moins catégorique. Compte tenu de cette accélération, il n’est pas impossible que l’on parvienne à fabriquer un jour ce qui pourrait ressembler aux mécanismes de la conscience. C’est pour cette raison que nous devons prendre le temps de réfléchir à ce que nous voulons, et n’engager ces recherches et déploiements qu’en tenant compte de l’utilisation qui pourrait en être faite.

TALI RANDALL

L’idée d’un moratoire est critiquée, notamment par certains de vos pairs, qui vous reprochent une vision catastrophiste. Que leur répondez-vous ?

On nous reproche de faire peur alors que ces risques ne sont pas certains. Mais c’est justement l’incertitude liée à ces technologies qui me conduit à alerter. Je ne peux pas donner le scénario précis de la façon dont la situation peut basculer, mais personne ne peut m’apporter la garantie que cela n’arrivera pas.

L’idée s’est imposée à moi depuis plusieurs années que, plus ces outils deviendront puissants, plus l’IA sera à la fois incroyablement utile et démesurément dangereuse. Peut-on accepter le risque de tout perdre pour doubler son avoir ? C’est un marché qui me semble inacceptable à l’échelle de l’humanité. Il nous faut trouver les moyens de profiter des bénéfices en réduisant les risques.

Ce qui se joue avec l’IA est assez comparable à ce qui se passe pour le réchauffement climatique : on sait que des effets en cascade sont possibles, et qu’on n’aura peut-être aucun moyen de les contrôler à partir du moment où le point de bascule sera dépassé, mais on n’a pas les modèles mathématiques capables de bien anticiper ce moment. Face à de telles incertitudes, il me semble indispensable de mettre en avant le principe de précaution, pour le climat comme pour l’IA. C’est la raison pour laquelle il faut absolument un encadrement.

La demande d’un moratoire peut-elle être liée à des arrière-pensées commerciales, pour ralentir des sociétés qui ont pris de l’avance ?

Je comprends cette crainte, et j’espère que les signataires de la lettre sont tous de bonne foi. Mais, même si ce n’était pas le cas, ce genre d’arrière-pensée me paraît dérisoire en comparaison des enjeux éthiques. C’est vrai que la grande majorité des sociétés qui travaillent sur l’IA ne veulent pas ralentir, car les profits en jeu sont colossaux. Il existe cependant des voix plus discrètes, au sein de ces compagnies, qui souhaitent une réglementation afin que tous les compétiteurs soient tenus aux mêmes limites.

Aujourd’hui, l’IA, c’est le Far West ! Le développement de ces outils n’est pas régulé, ou alors seulement par des lois très générales et peu protectrices. Cette absence de réglementation avantage les équipes qui prennent le moins de précautions et se soucient peu d’éthique.

N’est-il pas irréaliste de vouloir arrêter des recherches pendant six mois ?

Il existe une confusion entre les termes. Nous ne demandons pas un arrêt de la recherche sur l’IA mais une pause pour un petit nombre de systèmes entre les mains d’une poignée de compagnies. Il est important de souligner que les développeurs d’OpenAI [l’entreprise qui a lancé ChatGPT] ne font pas un travail de chercheur mais plutôt de l’ingénierie, en utilisant tout ce qui a été découvert ces dernières années dans le domaine de l’apprentissage profond. A l’inverse, les chercheurs universitaires n’ont pas les moyens de développer de tels systèmes…

On ne peut pas continuer avec des décisions qui, alors qu’elles touchent autant la société, sont laissées aux seules entreprises qui ont les moyens de développer ces outils. Ralentir l’innovation a un coût, mais cela en vaut la peine. Cette pause est nécessaire pour réfléchir collectivement aux aspects techniques, sociaux et juridiques de ces innovations. Comment développer la recherche pour que ces IA soient plus contrôlables et fiables ? Avec quels objectifs pour l’humanité ? Comment encadrer ces techniques ? Nous devons ralentir pour décider ensemble quelles applications bénéfiques et plus ciblées d’IA nous souhaitons pour l’humanité.

Comment définir les bénéfices d’une application ?

Il existe de nombreux systèmes d’IA prometteurs dans les domaines de la santé, de l’environnement, de l’éducation, de la justice sociale… Certains peuvent aider à diagnostiquer des cancers de façon plus fine et plus précoce. En climatologie, nous sommes en train de tester à MILA [l’institut québécois d’intelligence artificielle] un système qui modélise la planète à partir des images satellites, afin de mieux prévoir les changements liés au dérèglement climatique. On voit mal comment ce type d’outils pourrait être détourné à des fins dangereuses.

Ne craignez-vous pas qu’une pause laisse le champ libre à des Etats pour lesquels la désinformation est une arme ?

Les Etats autoritaires n’ont pas accès à de tels systèmes aujourd’hui. Même la Chine est en retard par rapport au développement mené par des compagnies américaines comme Google, Microsoft, OpenIA et Meta. Par ailleurs, ces nouveaux outils représentent aussi un danger pour les régimes non démocratiques qui ont besoin du soutien de leur population. Ils peuvent avoir un intérêt à ralentir le développement de systèmes qu’ils ne peuvent contrôler, et qui sont capables d’influencer l’opinion.

De nombreuses organisations intergouvernementales, comme l’Organisation de coopération et de développement économiques et l’Unesco, ont déjà publié des recommandations. N’est-ce pas suffisant ?

Ce sont de très bonnes recommandations, mais il faut passer à l’étape législative. Pour l’instant, aucun pays n’a voté de loi encadrant l’IA. L’Europe a élaboré un projet de directive qui n’est pas encore voté. Le Parlement canadien va bientôt examiner en seconde lecture une loi énonçant des grands principes, qui devront être précisés dans un deuxième temps. Il faut accélérer.

Dans de nombreux domaines civils, le transport aérien, l’alimentation, la chimie ou les médicaments, des systèmes de réglementation internationaux existent. On a réussi aussi à signer des traités internationaux dans le secteur militaire, sur les armes nucléaires, chimiques, biologiques. On a interdit le clonage humain. Il serait étrange que l’on ne se préoccupe pas de la même façon d’un domaine aussi sensible que l’IA.

Regrettez-vous d’avoir permis, par vos travaux, la mise au point de ces systèmes ?

Pour le regretter aujourd’hui, il aurait fallu que je puisse anticiper, ce qui n’était pas évident à l’époque. En revanche, je me sens une responsabilité de parole qui me pousse à m’engager, au risque de n’être pas toujours bien vu par certains collègues. Je l’ai fait dans le passé sur d’autres dangers liés à l’IA, comme les capacités des drones tueurs, qui m’inquiètent, dans une période où la guerre est revenue en Europe. Là aussi, il faut négocier un cadre.

Avec l’arrivée de ChatGPT, je me réjouis que les questionnements sur ces technologies commencent à se diffuser à l’ensemble de la société, même si je regrette que beaucoup de chercheurs ne tiennent pas compte du principe de prudence.